数据像雨水一样渗透到企业的每个角落。我们每天产生2.5万亿字节的数据量,这个数字还在持续增长。面对如此庞大的数据洪流,企业如何有效管理报告数据已经成为决定成败的关键因素。

报告数据管理不仅仅是整理表格和数字。它关乎企业能否在正确的时间,将准确的数据传递给需要的人。想象一下,销售团队需要实时业绩报告制定下季度策略,财务部门依赖精确数据完成合规申报,管理层依据数据分析做出战略决策——这些都建立在可靠的报告数据管理基础上。

我记得去年接触的一家制造企业,他们使用传统Excel表格管理生产报告。不同部门的数据格式各异,更新周期混乱,导致管理层看到的总是“过期”信息。这种数据滞后直接影响了产能规划,造成库存积压和资源浪费。

现代企业面临的三大核心挑战尤为突出:数据孤岛现象普遍存在,各部门使用独立系统导致数据难以互通;数据质量参差不齐,重复记录和错误信息严重影响决策准确性;合规要求日益严格,GDPR等法规对企业数据管理提出更高标准。

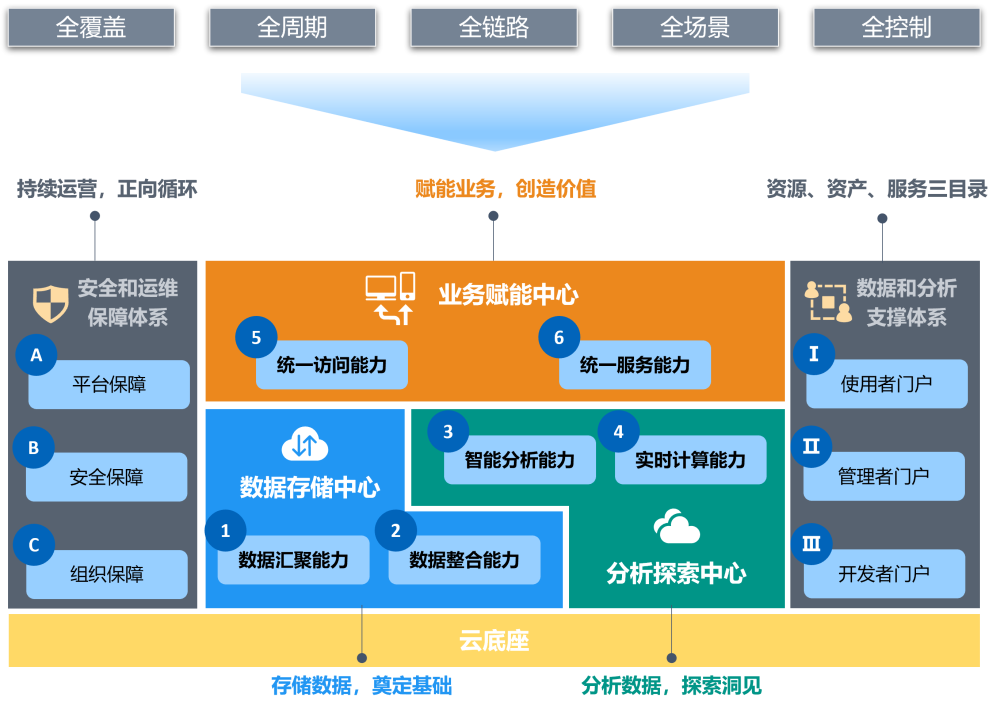

云计算平台让数据存储和处理变得弹性可扩展。企业不再需要投资昂贵的基础设施,就能获得强大的数据处理能力。某零售企业通过云端数据仓库,将原本需要数小时的报告生成时间缩短至分钟级别。

人工智能技术正在改变传统数据清洗方式。机器学习算法能够自动识别异常数据,智能匹配重复记录,大幅提升数据质量。我注意到一个有趣的现象:采用智能数据验证的企业,其报告错误率平均下降超过60%。

API集成技术打通了系统间的数据壁垒。销售数据从CRM系统自动同步至分析平台,财务信息从ERP系统实时更新到报告模板——这种无缝连接创造了真正意义上的实时报告环境。

自助式分析平台成为新宠。业务人员无需技术背景,通过拖拽操作就能生成专业报告。这种转变解放了IT部门,也让数据洞察更加及时。Tableau和Power BI这类工具的普及就是最好证明。

实时数据处理需求显著增长。批处理模式逐渐被流处理技术取代,企业希望立即看到业务变化带来的影响。就像开车时需要实时仪表盘,而非昨天的高速记录。

数据治理走向自动化和智能化。元数据管理、数据血缘追踪、自动质量监控——这些功能正在从“奢侈品”变成“必需品”。良好的数据治理不仅确保合规性,更提升了整个组织的决策质量。

数据安全被提到前所未有的高度。随着远程办公常态化,确保数据在传输和存储过程中的安全性变得至关重要。多因素认证、端到端加密成为标准配置。

我们正处在一个激动人心的转折点。报告数据管理从后台支持角色,逐渐走向企业运营的核心位置。它不再是简单的数据整理,而是驱动企业智能决策的关键引擎。

技术正在重新定义我们处理报告数据的方式。那些曾经需要人工核对、手动录入的繁琐流程,现在正被智能系统悄然取代。走进任何一家现代化企业的数据中心,你会看到的不再是成堆的纸质报告,而是流动的数据河流,在精心设计的技术架构中奔腾不息。

云已经成了数据管理的新家园。企业不再需要自建机房、维护服务器,而是按需租用计算资源。这种转变就像从自建水井转向使用自来水——打开开关,数据能力源源不断。

某金融科技公司的案例让我印象深刻。他们迁移到云端大数据平台后,原本需要通宵运行的风险报告现在只需15分钟。更妙的是,业务高峰期可以自动扩容,闲时又能缩减资源,成本控制变得异常精准。

大数据平台的核心优势在于处理多样性数据。结构化数据来自传统数据库,半结构化数据包括日志文件和XML文档,非结构化数据涵盖邮件和社交媒体内容——这些都能在同一个平台和谐共处。Hadoop和Spark这类框架让海量数据处理变得可行且经济。

存储成本的大幅下降改变了数据保留策略。企业现在可以保存更长时间的历史数据,为长期趋势分析提供丰富素材。就像保存家族相册,随时可以翻看多年前的模样。

数据质量一直是个棘手问题。传统规则引擎只能捕捉已知模式,而AI却能发现隐藏的异常。它像一位经验丰富的老校对,不仅找出错别字,还能察觉逻辑矛盾。

机器学习模型通过持续学习,不断提升识别数据异常的能力。比如自动检测销售额的异常波动,识别重复客户记录,甚至预测哪些数据字段可能包含错误。我曾见过一个智能清洗系统,它能识别出“北京市朝阳区”和“北京朝阳区”实际指向同一地点——这种语义理解远超传统规则。

自然语言处理技术让非结构化数据变得可分析。客服录音、邮件内容、社交媒体评论——这些文本数据都能转化为结构化信息,丰富报告维度。想象一下,客户满意度不再仅依赖评分,而是综合了所有渠道的语音情感分析。

预测性质量监控成为现实。系统能够提前预警数据质量下降的趋势,比如某个数据源的整体准确性开始滑坡。这种预见性维护避免了报告产出后的尴尬修正。

区块链不只是加密货币的专属。在报告数据管理领域,它提供了不可篡改的审计轨迹。每个数据变更都被永久记录,就像刻在石头上的账本,无法擦除或修改。

数据溯源变得透明可信。从原始数据采集,到中间处理环节,最终生成报告——整条数据链清晰可见。审计人员可以轻松追踪报告中每个数字的来源,大大简化合规流程。

智能合约自动执行数据验证规则。当新数据进入系统时,预设的验证条件自动触发,只有通过检查的数据才能进入下一环节。这种自动化不仅提高效率,还消除了人为疏忽的风险。

分布式存储增强了数据安全性。报告数据被加密分片后存储在不同节点,即使某个节点被攻破,攻击者也无法获得完整信息。这种设计特别适合处理敏感财务数据或医疗记录。

权限管理变得更加精细。基于区块链的身份验证确保只有授权人员才能访问特定数据,而且所有访问记录都被永久保存。这在满足GDPR等隐私法规要求方面表现出色。

API成了数据世界的通用语言。不同系统通过API对话,打破了长期存在的数据孤岛。销售数据自动流向营销报告,库存信息实时更新到供应链看板——数据开始自由流动。

我曾经参与一个跨国企业的数据整合项目。他们通过API连接了全球23个分支机构的ERP系统,实现了财务报告的自动合并。原本需要两周完成的月度结算,现在三天内就能产出初步报告。

自动化数据处理流水线减少了人为干预。数据从源系统抽取后,自动进行格式转换、质量检查、关联匹配,最终加载到目标数据库。这种端到端的自动化不仅加快处理速度,还显著降低错误率。

微服务架构让系统更加灵活。每个数据处理功能都封装为独立服务,可以根据需求单独升级或扩展。就像乐高积木,随时组装出新的数据处理流程。

实时数据同步成为标准配置。传统批量更新被持续数据流取代,报告始终反映最新业务状态。决策者看到的不再是历史快照,而是活生生的业务脉搏。

这些技术正在协同工作,构建出智能、高效、可靠的报告数据管理体系。它们不再是孤立的工具,而是紧密配合的生态系统,共同推动企业向数据驱动转型。

数据管理流程就像企业的血液循环系统——每个环节都需要顺畅衔接,任何阻塞都会影响整体健康。优化这些流程不是简单地引入新技术,而是重新思考数据如何流动、如何转化、如何创造价值。我见过太多企业投入昂贵技术却收效甚微,问题往往出在流程设计上。

数据采集是整条流水线的源头。源头水质决定下游所有环节的质量。现代企业需要采集的数据源极其多样:从传统数据库到云应用,从物联网传感器到社交媒体流。

智能数据采集应该像精明的采购员——知道该买什么、从哪里买、花多少钱买。我们曾经帮助一家零售企业重新设计采集策略,他们原本试图记录顾客在店内的每个动作,结果数据泛滥却缺乏洞察。后来改为聚焦关键行为路径,数据量减少70%,价值反而提升三倍。

API优先的整合策略正在成为主流。与其等待数据导出导入,不如让系统直接对话。RESTful API就像数据世界的通用翻译官,让不同语言的应用能够流畅沟通。实时数据流逐步取代传统的批量传输,业务动态能够即时反映在报告中。

元数据管理经常被忽视,实际上它是数据的“身份证”。完整记录每个数据的来源、格式、含义和关系,后续处理才会顺畅。建立统一的数据目录,让所有数据资产一目了然。这就像给图书馆的每本书都配上详细的索引卡片。

数据采集需要平衡全面性与实用性。过度收集不仅浪费资源,还可能触及隐私红线。明确每个数据的业务用途,无用数据不采集——这个原则说起来简单,执行起来需要极大克制。

数据清洗不再是简单的去重和格式标准化。现代方法更注重语义理解和上下文感知。智能清洗工具能够识别“张伟先生”和“张伟”指向同一人,而“北京市”和“北京”本质相同。

质量控制应该贯穿整个流程,而非最后一道关卡。我们在每个关键节点设置质量检查点,就像生产线上的质检员。异常数据立即被标记并路由到处理队列,避免污染下游环节。

机器学习为质量控制带来革命性变化。监督学习模型通过历史样本训练,能够识别各种数据异常模式。无监督学习则能发现前所未见的异常类型。我特别喜欢的一个案例是某银行的反欺诈系统,它通过学习正常交易模式,成功拦截了全新的欺诈手法。

数据质量评分体系让抽象概念变得可衡量。每个数据集都会获得综合质量分数,包括完整性、准确性、一致性、时效性等维度。这个分数直接影响数据在决策中的权重——低分数据需要额外验证才能使用。

自动化修复规则需要谨慎设计。某些明显错误可以自动修正,比如统一日期格式。但涉及业务逻辑的修正必须人工审核。建立修复日志和回滚机制,确保所有变更可追溯。

存储方案的选择直接影响数据访问效率和成本。热数据需要高速SSD存储,温数据适合标准云存储,冷数据则可以归档到低成本方案。这种分层存储就像衣柜整理——常穿衣服放在顺手位置,过季衣物收纳起来。

云原生存储架构提供前所未有的弹性。按需扩容不再需要采购硬件,几个点击就能获得PB级容量。自动化的生命周期管理让数据在不同存储层级间智能迁移,优化成本的同时保证性能。

备份策略已经从“以防万一”进化到“业务连续性”。传统的定时备份无法满足实时业务需求。持续数据保护技术能够记录每个数据变更,实现任意时间点的精确恢复。某电商平台遭遇数据损坏后,通过这种技术只丢失了2分钟的交易记录。

数据加密不再可选,而是必备。静态数据加密保护存储中的数据,传输加密确保数据移动安全。密钥管理需要专业方案,自行保管密钥就像把家门钥匙放在花盆下面——看似隐蔽实则危险。

合规要求深刻影响存储设计。GDPR的“被遗忘权”要求数据能够彻底删除,某些行业法规要求数据本地化存储。这些约束需要在架构设计阶段就充分考虑,后期改造往往代价高昂。

可视化工具正在从“展示数据”转向“讲述故事”。静态图表逐渐被交互式仪表板取代,用户能够钻取细节、调整参数、探索关联。优秀的可视化让数据自己说话,无需额外解释。

自然语言生成技术让报告撰写自动化。系统分析数据后,自动生成文字描述和洞察结论。某媒体公司的财报分析系统能够在一分钟内产出千字分析,涵盖关键指标解读和趋势预测。

个性化报告成为新标准。不同层级、不同部门的用户看到定制化内容。销售总监关注成交转化,财务总监紧盯现金流,CEO需要战略概览——同一数据源,不同视角呈现。

移动优先的设计理念深入人心。管理人员越来越多通过手机和平板查阅报告,界面必须适应小屏幕触控操作。推送通知让关键指标异常能够即时提醒,就像随身携带的数据警报器。

协作功能融入报告工具。用户可以在图表上添加批注、分享洞察、发起讨论。数据不再是孤立的数字,而是团队对话的起点。这种转变让报告从单向传递变为双向交流。

流程优化是个持续旅程,没有终点可言。技术迭代、业务变化、法规更新都在推动流程进化。建立定期回顾机制,就像汽车定期保养,确保整个数据管理体系始终处于最佳状态。

数字化转型就像装修老房子——不能把新家具直接塞进旧空间,需要先拆墙布线、重新规划功能分区。我参与过不少企业的数字化项目,发现成功案例都有个共同点:他们把实施过程看作系统工程,而非单纯的技术采购。记得有家制造企业,他们花了半年时间做前期准备,实际部署只用了一个月,这种“慢准备、快执行”的节奏反而让项目提前两周完工。

评估现状不是简单盘点现有系统,而是要理解数据在组织中的真实流动路径。我们经常使用“数据旅程地图”这个方法,跟踪关键数据从产生到决策的完整生命周期。某次评估中,我们发现一份月度销售报告竟然要经过17次手工转换——这种隐藏的低效只有通过端到端追踪才能暴露。

需求分析要区分“想要”和“需要”。各部门提出的需求清单往往很长,但核心需求可能只占20%。通过需求优先级矩阵,我们把需求分为四类:必须实现、应该具备、可以等待、不必考虑。这个方法帮助一家金融机构在预算削减时,依然保住了核心功能。

数据成熟度评估给出客观基准。从初始级的零散Excel,到优化级的预测分析,每个层级对应不同的能力要求。这个评估不仅看技术,还考察人员技能、流程规范和数据文化。成熟度模型就像体检报告,指出强项和待改善领域。

业务目标必须转化为具体的数据指标。如果战略是“提升客户满意度”,就要定义如何测量满意度,数据从何而来,目标值是多少。模糊的目标会导致后续技术选型失去方向。我经常提醒团队:无法测量的目标,等于没有目标。

技术选型面临“建造还是购买”的经典抉择。现成方案实施快但定制有限,自建系统控制强但周期长。混合策略正在流行——核心平台采用成熟产品,差异化功能自主开发。这种思路就像装修时选择标准厨卫+定制衣柜,平衡效率与个性化。

架构设计要预留扩展空间。我们设计系统时通常规划三年内的容量需求,同时确保架构能适应未知的技术变革。微服务架构让各组件独立演进,某个模块的技术升级不会影响整体稳定。这好比城市规划,既要满足当前交通流量,又要为未来地铁线路预留空间。

集成设计决定系统生命力。新系统需要与现有ERP、CRM等核心业务系统无缝对接。API经济让集成变得更简单,但需要建立统一的集成标准和治理规范。某零售企业建立了“集成中心”,所有系统通过这个枢纽交换数据,避免了复杂的点对点连接。

安全与合规必须内嵌而非外挂。从设计阶段就考虑数据加密、访问控制、审计追踪。隐私设计原则要求系统默认保护用户数据,只收集必要信息。欧盟某项目因为早期忽略了隐私设计,后期改造费用超出预算三倍——这个教训值得铭记。

分阶段部署降低项目风险。我们偏好“试点-推广”模式:先在一个业务单元验证方案,修复问题后再全面铺开。试点阶段要选择有代表性但风险可控的场景,比如某个区域分公司或产品线。小步快跑比大跃进更可能到达终点。

变更管理关乎人心向背。新技术再好,如果用户抵触也会失败。我们建立“变革代言人”网络,在每个部门培养积极用户,通过同侪影响带动整体接纳。某次实施中,财务部老张从最抗拒变成最积极,他的转变说服了整个团队。

培训设计要匹配不同学习风格。有人喜欢手册,有人偏好视频,有人需要手把手指导。我们制作了五分钟短视频、交互式模拟环境、快速参考卡等多种材料。关键操作录制屏幕演示,配上语音解说——这种形式最受业务用户欢迎。

支持体系确保平稳过渡。上线初期设立“作战室”,技术团队和业务专家集中办公,快速响应问题。建立分级支持机制:一线帮助台解决常见问题,专家团队处理复杂情况。知识库积累解决方案,让支持效率随时间提升。

监控指标要平衡结果与过程。除了系统正常运行时间、数据处理速度等传统指标,我们还跟踪业务价值指标:报告使用率、决策采纳率、用户满意度。某公司发现某个昂贵报表无人使用后,及时调整资源投向更受欢迎的分析功能。

反馈循环驱动持续改进。我们建立多种反馈渠道:定期用户访谈、匿名建议箱、使用数据分析。特别关注“静默投诉”——用户不再使用某些功能,这种反馈往往比直接抱怨更有价值。就像餐厅老板关注剩菜比投诉信更准确。

技术债需要定期偿还。快速开发阶段做出的妥协,要在稳定期逐步重构。每个迭代周期预留20%时间用于优化和还债。忽视技术债就像只开车不保养,迟早要抛锚。

能力建设是长期投资。技术迭代速度远超培训周期,我们建立持续学习机制:内部技术分享、外部专家讲座、在线课程订阅。某企业设立“数据星期五”,每周五下午分享最新工具和案例,这种习惯保持了团队的技术敏感度。

数字化实施从来不是交钥匙工程,而是持续演进的伙伴关系。最好的系统会随着组织一起成长,像合身的西装需要定期调整。每次优化都是新的开始,这个认知让团队保持谦卑又充满活力。

看着那些成功驾驭数据洪流的企业,总让我想起冲浪高手——他们不是与海浪对抗,而是借助浪潮的力量优雅前行。去年拜访的一家医疗科技公司给我留下深刻印象,他们的CEO指着实时更新的业务仪表盘说:“这不再只是报表,而是我们的数字心跳。”这种将数据融入组织生命线的境界,正是数字化管理的终极目标。

全球物流巨头的实时数据指挥中心令人震撼。他们整合了运输、仓储、海关等15个系统的数据,任何包裹的异常停留都会触发预警。我站在他们那面巨大的数据墙前,看到的不再是冰冷的数字,而是流动的商业价值。特别欣赏他们的“数据民主化”理念——从仓库管理员到区域总裁,每个人都能自助生成需要的分析报告。

某跨国零售商的智能补货系统堪称典范。传统模式下,门店经理凭经验下单,现在AI模型综合天气、促销、社交媒体热度等200多个因子生成建议订单。实施首年,库存周转率提升30%,缺货率下降至历史最低。有趣的是,系统最初遭到采购团队的强烈抵制,直到一次台风前夕,系统提前建议增加雨具备货,避免了百万损失。

金融服务机构的风控转型同样值得借鉴。他们构建的实时反欺诈平台,能在0.8秒内完成交易评分,误报率比传统规则引擎降低60%。技术负责人分享心得时说:“关键不是算法多先进,而是我们重新设计了整个数据供应链——从数据采集到决策执行的每个环节都经过数字化重塑。”

制造业的预测性维护案例展示了工业数据的力量。通过在关键设备安装传感器,他们提前两周预测到某生产线轴承故障,避免了三天停产损失。工厂总监的感慨很生动:“以前我们按计划更换零件,现在零件会‘告诉’我们何时需要关注。”

数据孤岛依然是最大障碍。各部门的系统像独立王国,数据标准各异。某消费品公司用“数据联邦”思路破解困局——不强制迁移所有数据,而是建立统一语义层,让业务用户无感知地访问分散数据。这就像给各个仓库配了标准集装箱,货物不必集中存放也能顺畅流转。

数据质量问题是永恒挑战。我们常发现企业有70%时间花在数据清洗上。某互联网公司的解决方案很巧妙:他们开发了数据质量“健康码”,每个数据集都有实时评分,低分数据自动进入修复流程。业务用户看到健康码就知道数据可信度,技术团队则能精准定位问题源头。

技术债积累导致系统僵化。见过太多企业被十年前的技术选择所困。某金融机构采用“ strangler pattern”渐进式替换——在旧系统外围构建新功能,逐步“绞杀”遗留系统。就像珊瑚礁生长,新生态慢慢覆盖旧基底。

人才缺口制约发展。既懂业务又懂数据的复合型人才稀缺。成功企业的做法是建立“数据伙伴”制度,每个业务部门配备专职数据分析师。这些分析师像派驻大使,帮助业务团队用数据思考,同时把业务需求精准传达给技术团队。

AI正在从工具变成伙伴。下一代系统将具备对话式交互能力,你可以直接问:“为什么本季度华东销量下滑?”系统会像资深分析师那样解读数据。我试用过某实验性平台,它不仅能回答问题,还会主动推送你可能关心的洞察——比如突然提醒:“注意到竞争对手在西南地区降价,建议调整定价策略。”

边缘计算带来实时性革命。随着5G普及,数据处理正从云端向边缘迁移。想象一下,零售摄像头实时分析客流量,工厂传感器即时调整设备参数。这种“数据在原地决策”的模式,将极大减少云端传输延迟。某自动驾驶公司已经在车辆端完成90%的数据处理,只有关键事件才上传云端。

数据编织(Data Fabric)概念开始落地。这种架构像智能数据中介,理解业务语境,自动推荐最适合的数据源和处理方法。它知道财务报告需要审计轨迹,营销分析更看重实时性。未来可能不再需要手动集成数据,系统会像管家那样为你准备好一切。

隐私增强技术成为刚需。差分隐私、联邦学习等技术让数据“可用不可见”。某医疗研究项目让我印象深刻:多家医院合作训练AI模型,却无需共享患者原始数据。这种“数据不动算法动”的模式,很可能成为跨组织协作的新标准。

文化转型比技术升级更重要。成功企业都把数据文化植入组织基因。他们庆祝“数据驱动决策”的成功案例,哪怕初期结果不如预期。某公司甚至设立“最佳失败洞察奖”,鼓励团队从数据中学习而非惧怕犯错。这种心理安全感是创新土壤。

治理框架需要弹性与原则的平衡。太松会导致混乱,太紧会抑制创新。我们帮助某企业建立的“护栏式治理”效果不错——核心数据标准必须遵守,但在安全边界内鼓励实验。就像儿童学骑车,训练轮初期提供保护,熟练后自然拆除。

价值闭环确保投入持续。每个数据项目都要明确业务价值,并定期验证回报。某制造商采用“数据投资委员会”模式,像管理产品组合那样管理数据项目,及时终止低效投入,加大成功实践推广。他们的CFO说得好:“我们要的是数据价值,不是数据虚荣。”

生态系统思维打破组织边界。最先进的企业开始与供应商、客户共享数据,创造更大价值。某汽车厂商与零部件供应商实时共享生产数据,供应商能提前调整产能,整个供应链像交响乐团般和谐运作。

未来已来,只是分布不均。站在今天的转折点,我们既要脚踏实地解决眼前问题,又要仰望星空规划长远。最好的数据管理体系应该像健康生态系统——有足够的多样性应对变化,有足够的韧性承受冲击,有足够的活力持续进化。每次技术变革都是重新思考的契机,这个认知让数据管理之旅充满惊喜。

本文地址: https://www.ishool.com/post/589.html

文章来源:facai888

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

2025-11-07facai888

2025-11-07facai888

2025-11-07facai888

2025-11-07facai888

2025-11-07facai888

2025-11-07facai888

2025-11-07facai888

2025-11-06facai888

2025-11-06facai888

2025-11-06facai888

2025-10-07facai888

2025-10-07facai888

2025-10-07facai888

2025-10-07facai888

2025-10-11facai888

2025-10-11facai888

2025-10-12facai888

2025-10-07facai888

2025-10-07facai888

2025-10-11facai888

2025-11-04facai888

2025-11-04facai888

2025-11-03facai888

2025-11-05facai888

2025-11-03facai888

2025-11-06facai888

2025-11-03facai888

2025-11-04facai888

2025-11-05facai888

2025-11-05facai888

扫码二维码

获取最新动态