想象一下,你正在教一个孩子认识“苹果”。你不仅会说出这个词,还会展示红色圆润的水果图片,甚至让孩子听到咬苹果的清脆声响。多模态大模型就像这个学习过程——它不再局限于单一信息渠道,而是同时处理文本、图像、音频、视频等多种数据形式。

这类模型最显著的特征在于其庞大的参数规模。动辄千亿级别的参数让它们具备惊人的学习容量,就像拥有一个超大型信息处理中心。我记得第一次接触多模态模型时,惊讶于它如何将截然不同的数据类型关联起来——比如理解“夕阳西下”这段文字与金色天空图片之间的深层联系。

多模态模型的魅力在于它的整合能力。它不会将图像和文本视为孤立的信息片段,而是寻找它们之间的内在关联。当看到海浪图片时,它不仅能识别出“海洋”,还能联想到“潮湿”、“咸味”甚至“度假”这些跨模态概念。

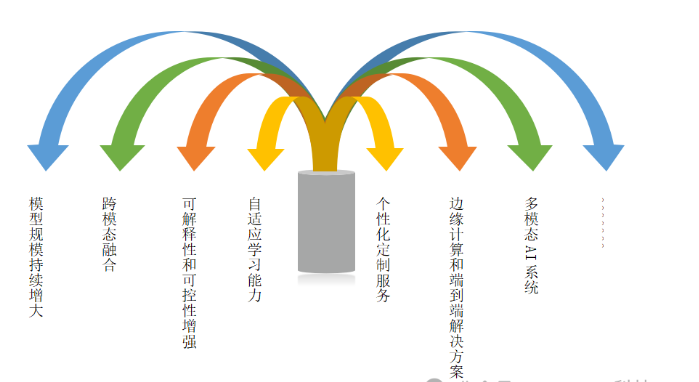

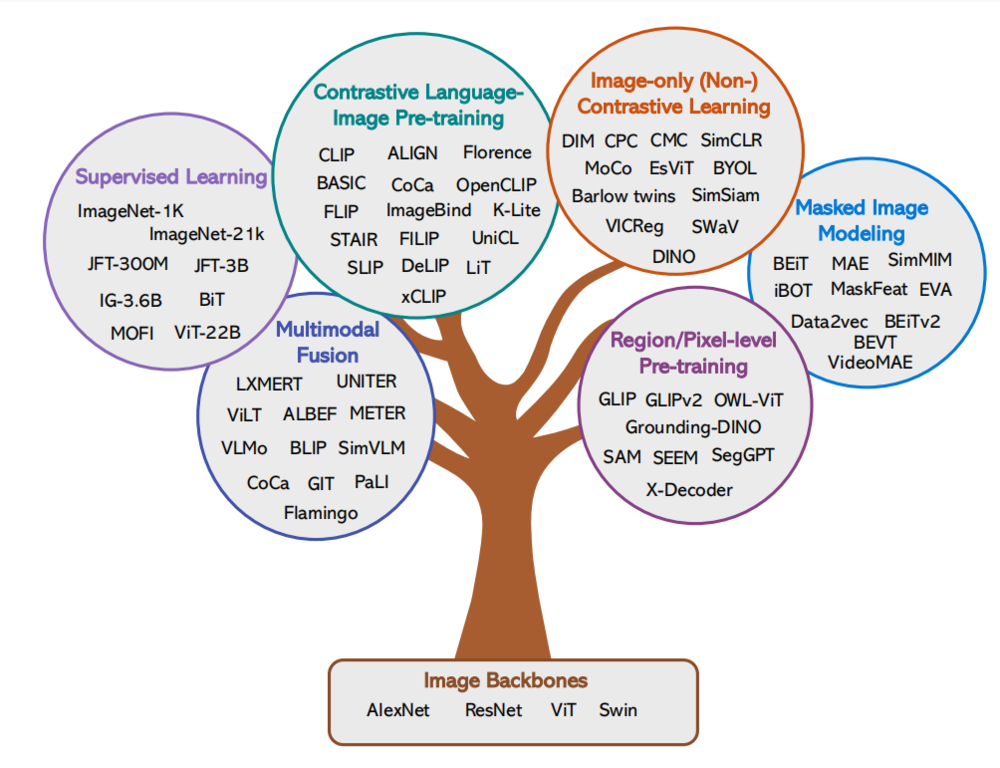

技术发展总是充满惊喜。早期的多模态系统往往采用拼接式架构——分别处理不同模态后再强行融合。这种方法就像让几个专家各自为政,缺乏真正的协同。

近年来,我们见证了从单模态到原生多模态的质变。以智源研究院的Emu3为例,它采用的自回归框架实现了真正的多模态统一处理。这种架构上的突破让我想起数码相机取代胶片相机的过程——不是简单的升级,而是根本性的范式转变。

传统方法依赖CLIP视觉编码器或扩散模型,本质上还是在不同模态间搭建桥梁。而新一代模型直接构建了多模态的“通用语言”,让文本、图像、视频在同一个空间里自由对话。这种演进不仅仅是技术改进,更是思维方式的革新。

token化处理是多模态模型的核心魔法。Emu3采用的新型视觉tokenizer将图像和视频离散化为token序列,就像把连续的世界分解成可理解的“词汇”。这种处理方式创造了一种奇妙的效果——不同的模态开始在同一个语义空间里交流。

我特别喜欢这个比喻:多模态统一表征就像建造了一座巴别塔,让原本说着不同“语言”的数据类型能够顺畅沟通。文本token和视觉token不再需要翻译就能直接互动,这种设计确实极大地简化了模型结构。

这种统一表征带来的直接好处是效率提升。模型不再需要为每个模态维护独立的处理管道,所有信息都在同一个框架下流动。从工程角度看,这种设计减少了模块间的接口损耗,让模型能够更专注于学习跨模态的深层关联。

训练多模态模型就像培养一个全能运动员,需要平衡各种技能的发展。直接偏好优化(DPO)机制在这方面表现出色,特别是在对齐人类偏好方面。这种优化方法让模型生成的内容更符合我们的审美和需求。

在实际训练中,数据配比是个微妙的问题。文本数据通常丰富易得,而高质量的视觉数据相对稀缺。找到合适的平衡点需要反复试验——太多文本会让模型偏向语言理解,太多图像又可能削弱其推理能力。

损失函数的设计也充满艺术性。多模态训练不能简单套用单模态的损失函数,需要设计能够捕捉跨模态关联的特殊指标。这让我想起调音师的工作,需要在不同频段间找到完美平衡。

模型优化过程中,正则化技术尤为重要。过大的参数规模容易导致过拟合,特别是在数据分布不均匀的情况下。适当的正则化就像给模型系上安全带,确保它在探索新知识时不会偏离太远。

社交媒体平台正在悄悄改变我们获取信息的方式。当你上传一张聚会照片并配上文字描述时,多模态模型正在背后默默工作——它同时分析图像内容和文字评论,生成更精准的内容标签。这种能力让内容推荐不再局限于关键词匹配,而是真正理解你想要表达的情感与场景。

跨模态搜索正在重新定义“寻找”这件事。输入“夕阳下的海滩”,系统不仅返回相关图片,还能找到描写黄昏海岸的诗歌、海浪声音频,甚至相关旅游攻略。这种搜索体验就像有个懂你的助手,它理解文字描述背后的视觉期待,也明白图片中蕴含的文本信息。

推荐系统的变革更令人惊喜。平台根据你喜欢的电影,不仅推荐类似影片,还可能推荐原著小说、电影原声带,甚至是片中出现的同款服饰。这种跨模态的关联推荐,往往能发现你自己都没意识到的兴趣点。我记得有次系统根据我常看的烹饪视频,推荐了一本关于食物摄影的书籍——这种跨越形式的推荐确实让人眼前一亮。

自动驾驶领域可能是多模态模型最严苛的考场。车辆需要同时处理摄像头图像、雷达点云、激光雷达数据,就像人类司机同时用眼睛观察、耳朵聆听、身体感受路面震动。多模态模型将这些信息融合,构建出比任何单一传感器都更可靠的环境感知。这种综合判断能力在恶劣天气下尤其重要——当摄像头因大雨受阻时,雷达数据仍能确保安全导航。

视频创作领域正在经历一场革命。制作团队输入剧本片段,多模态模型就能生成对应的场景草图、角色动作建议,甚至初步的对话配音。这种能力大幅降低了创作门槛,让更多创意能够快速可视化。有个独立导演朋友告诉我,他们用多模态工具在几小时内就完成了原本需要数天的手绘分镜工作。

多媒体处理的边界在不断拓展。现在,系统可以根据一段音乐自动生成匹配的视觉特效,或是根据文字描述实时渲染出对应的动画场景。这种跨模态的即时转换,让内容创作变得更加直观和富有想象力。

办公场景的智能化程度正在以惊人的速度提升。多模态模型能够自动处理会议录音,识别不同发言人的声音,同时分析演示文稿内容,最终生成结构清晰的会议纪要。这种能力不仅节省了行政人员的大量时间,更重要的是确保重要决策和行动项不会被遗漏。

金融行业的风险管理变得更加立体。模型同时分析企业财报文本、行业新闻情绪、市场走势图表,甚至高管演讲的语气变化,构建出全方位的风险评估。这种多维度的分析往往能发现传统方法忽略的风险信号——比如某公司财报措辞谨慎,但高管演讲却异常乐观,这种矛盾可能暗示着潜在问题。

电商体验正在变得更加个性化。用户上传一张心仪家具的照片,系统不仅能找到相似商品,还能根据房间尺寸推荐合适规格,甚至模拟摆放效果。虚拟试穿功能让在线购物少了些不确定性——看到衣服穿在自己身上的效果,确实让购物决策更加安心。

医疗诊断正在获得新的助力。多模态模型同时分析患者的医学影像、化验报告文本和就诊记录,帮助医生发现不同信息源之间的隐含关联。这种综合判断在某些复杂病例中显得尤为重要,就像多位专家同时会诊,从不同角度审视同一个问题。

智能安防系统变得更加敏锐。监控摄像头捕捉画面时,多模态模型同时分析视觉信息和环境声音。当识别到异常行为模式与求救声的匹配时,系统能立即发出警报。这种多感官的协同判断,大大减少了误报率,也让应急响应更加及时。

教育领域的变化同样令人期待。想象一个能同时理解学生文字作业、手写公式、甚至解题过程录音的学习助手。它不仅能判断答案对错,还能分析学生的思考路径,提供个性化的学习建议。这种全方位的辅导,或许能真正实现因材施教的理想。

未来,多模态模型可能会更加深入地融入我们的日常生活。从能理解手势和语音的智能家居,到可以感知驾驶员状态的车载系统,这些应用都在让技术更好地服务于人类需求。或许某天,我们与机器的交流会像人与人交流一样自然——不需要特定指令格式,只需要用最习惯的方式表达自己。

本文地址: https://www.ishool.com/post/10.html

文章来源:facai888

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

2025-11-04访客

2025-11-04访客

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-11-04facai888

2025-10-07facai888

2025-10-07facai888

2025-11-04访客

2025-10-07facai888

2025-10-11facai888

2025-10-11facai888

2025-10-12facai888

2025-11-04访客

2025-10-07facai888

2025-10-11facai888

2025-10-17facai888

2025-10-16facai888

2025-10-11facai888

2025-10-11facai888

2025-10-11facai888

2025-10-17facai888

2025-10-11facai888

2025-10-11facai888

2025-10-17facai888

2025-10-17facai888

扫码二维码

获取最新动态